Als Webentwickler oder IT-Teammitglied können Sie nie über zu viele Daten verfügen, die die Leistung Ihrer Website und deren Vergleich mit anderen in der Branche beschreiben. Eine einfache Möglichkeit, zu verstehen, wie Ihre Website-Leistung im Vergleich zu einem Cross-Sampling des Internets dauert nur drei Schritte:

- Führen Sie eine Webleistungsbasislinie auf Ihrer Website mit einem Tool wie dem Website-Geschwindigkeitstestvon Dotcom-Monitor aus.

- Führen Sie eine Abfrage auf den Top 100- oder Top-1000-Websites mithilfe der Tools im HTTPArchiveaus.

- httpsArchive.org

- Vergleichen Sie die Daten, um zu sehen, wo Sie gegen die Branche stehen.

Dies gibt Ihnen einen großartigen Einblick in allgemeine Web-Performance-Analysen und Durchschnittswerte, aber Sie können nicht in die Details graben. Das von HTTP Archive erfasste Dataset ist enorm, weit über 400 GB. Wenn Sie jedoch davon leben, Millisekunden von einer Seitenladezeit zu rasieren, möchten Sie auf die größtmöglichen Daten zugreifen.

Web Performance Analytics an Ihren Fingerspitzen

Jetzt ist das vollständige HTTP-Archiv-Dataset auf BigQuery verfügbar, einem Google-Tool, mit dem Entwickler oder andere Interessierte Big Data in der Cloud analysieren können. Benutzer können SQL-ähnliche Abfragen für riesige Datasets ausführen und Ergebnisse in Sekunden erzielen. Jetzt können Sie sich selbst mit den detaillierten Web-Performance-Analysedaten in die detaillierten Web-Performance-Analysedaten einarbeiten und aufschlussreiche Nuancen zur Website-Performance entdecken. Wenn Sie dies noch nicht ausprobiert haben, verpassen Sie es. Sie können Web-Leistungsnummern nach Herzenslust knacken und sich eingehend analysieren lassen, wo Ihre Website in den Mix passt.

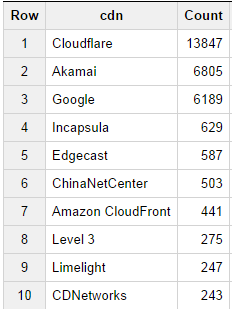

Sie können z. B. wirklich einfache Abfragen für riesige Datensätze ausführen und sofort Ergebnisse erhalten. Wir haben eine Abfrage ausgeführt, um die 10 beliebtesten Inhaltsverteilungsnetzwerke mit der folgenden Abfrage zu ermitteln:

[note note_color=“#e7e7e7″]SELECT cdn, Count(cdn) as Count FROM [httpsarchive:runs .2014_09_01_pages] WHERE cdn <> „“ GROUP BY cdn ORDER BY Count Desc;[/note]

[httpsarchive:runs .2014_09_01_pages] WHERE cdn <> „“ GROUP BY cdn ORDER BY Count Desc;[/note]

die die folgenden Ergebnisse lieferten:

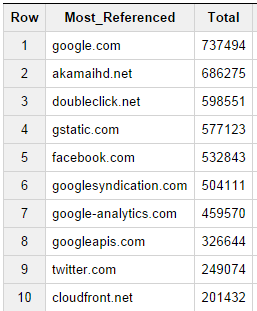

Wenn wir über die am häufigsten referenzierten CDNs nachdenken, haben wir uns auch gefragt, welche Websites im Allgemeinen das am häufigsten referenzierte Material hosten (z. B. Tracking-Code für Analysen usw.), also haben wir die folgende Abfrage ausgeführt, um diese Informationen abzurufen:

[note note_color=“#e7e7e7″]SELECT DOMAIN(req.url) Most_Referenced, COUNT(*) Gesamt

FROM [httpsarchive:runs .2014_09_01_requests] as req JOIN (

SELECT DOMAIN(url) selbst, pageid

Von [httpsarchive:runs .2014_09_01_pages] ) als Seiten ON pages.pageid = req.pageid

WO DOMAIN(req.url) != pages.self

GRUPPE VON Most_Referenced

ORDER VON Total desc;[/note]

Es überrascht nicht, dass einige der Vorläufer auf beiden Listen auftauchen, da Google, Akamai und Amazon Cloudfront alle als Hosts von Inhalten sowie als zusätzliche referenzierte Elemente weit verbreitet sind.

Diese Daten mögen für niemanden eine große Überraschung sein, aber diese Abfragen berühren wirklich nur die Spitze des Eisbergs. Sie können komplexere Abfragen schreiben, um die Webleistungsanalysedaten wirklich zu untersuchen und Inhalte zu identifizieren, die für Leistungsmetriken relevant sind, die Sie am meisten interessieren.

Noch besser ist die Möglichkeit, eine Kalkulationstabelle als Front-End für diese Big-Data-Verarbeitungsleistung zu verwenden. BigQuery verbindet sich jetzt mit Google Docs, sodass Benutzer Schnell und einfach Ergebnisse sehen und teilen können – mit dem Chef, interessierten Kollegen und mehr.

Hier ist ein großartiges Video von Google Developer Advocate Ilya Grigorik bei Velocity letztes Jahr, das genau beschreibt, wie man mit HTTP Archive Data auf BigQuery beginnt. Vergessen Sie nicht: Der erste Schritt besteht darin, Ihren Grundlegenden-Webleistungstest für Ihre eigene Website zu erhalten, damit Sie Benchmarks haben, um Ihre eigenen Web-Performance-Analysen mit dem Rest des Internets zu vergleichen.